News

L’intelligence artificielle, la confiance et la réglementation

La confiance est un point crucial pour l’adoption de l’intelligence artificielle. Car à l’heure actuelle, l’IA n’est plus dans un lointain horizon de science-fiction, elle est déjà bel et bien au cœur de la société. Que ce soit sur le plan scientifique, avec 5 478 publications sur l’IA en 2015 et 34 736 en 2020 d’après Stanford (1), ou sur le plan politique avec un sujet qui anime de nombreux débats sociétaux. Mais, même si l’IA va impacter le quotidien de beaucoup de gens, de par ses utilisations qui seront très nombreuses et très variées, pourquoi ne la voit-on pas déjà concrètement en action partout ? Simplement, car en l’état, l’IA ne peut pas encore être déployée opérationnellement dans de nombreux secteurs. Avant de pouvoir généraliser ces déploiements, il faut que les questions de confiance que soulève l’IA soient correctement adressées.

L’expression d’un besoin de sûreté

Si des questions de confiance se posent, c’est bien évidemment qu’elles reflètent certaines appréhensions. Les algorithmes ne sont jamais exempts de défauts, et les tâches qui leur sont attribuées peuvent échouer dans leur exécution. Les répercussions potentielles de ces défauts peuvent être importantes lorsque les algorithmes sont utilisés pour automatiser certaines tâches dans des cadres critiques.

Historiquement, de telles erreurs algorithmiques se sont déjà produites, avec des erreurs d’arrondi qui ont par exemple coûté la vie en 1991 à 28 soldats américains lorsqu’un missile Patriot a échoué l’interception d’un missile irakien. Ou encore, lorsqu’un problème de conversion numérique a été à l’origine de l’explosion de la fusée Ariane 5 en 1996, causant une perte estimée à plus de 500 millions de dollars (2).

L’IA, qui n’est rien de plus qu’un autre type d'algorithme, a également connu son lot de dysfonctionnements. Pour en citer quelques cas, en 2018 une voiture sans chauffeur a renversé et causé la mort d’un piéton après l’avoir confondu avec un objet sans avoir pu enclencher sa procédure de freinage d’urgence suite à un mauvais réglage (3). Également, les IA sont couramment affectées par des biais qui peuvent fausser leur fonctionnement. Par exemple, les algorithmes d’IA peuvent être victimes de biais d’apprentissage. Ces biais peuvent être introduits par une mauvaise représentativité, comme dans le cas d’un algorithme de reconnaissance faciale qui ne reconnaît pas les personnes de couleur car elles n’étaient pas assez représentées dans le jeu de données d’apprentissage (4).

Le développement des initiatives législatives

Ces exemples ont pu malheureusement alimenter des craintes mais ils mettent surtout en valeur les faiblesses des IA auxquelles il faut pallier. Améliorer les méthodes de construction des IA permet justement d’identifier ces risques pour mieux les réduire. L’enjeu est surtout, pour l’industrie, de développer des IA en suivant des principes éthiques qui faciliteront l’accord de la confiance du public à l’égard ces systèmes. Même si l’IA représente de grandes opportunités économiques, la gestion des risques reste un prérequis indispensable dans de nombreux cas d’utilisation. Pour cela, il est nécessaire de fixer un cadre qui permettra de contrôler le déploiement de cette technologie dans le but de dépasser les interdictions d’utilisation qui étaient jusqu’ici en vigueur. Effectivement, la technologie a évolué depuis plusieurs années et les risques associés à l’utilisation de l’IA peuvent maintenant être mieux contrôlés. Il est maintenant possible d’imaginer, d‘ici quelques années, de l’IA intégrée dans des secteurs comme le transport, la santé ou l’énergie, qui aujourd’hui ne les acceptent pas ou avec difficulté.

Le caractère horizontal et transnational de cette technologie en fait un enjeu international auquel les initiatives de standardisation et de réglementation veulent répondre.

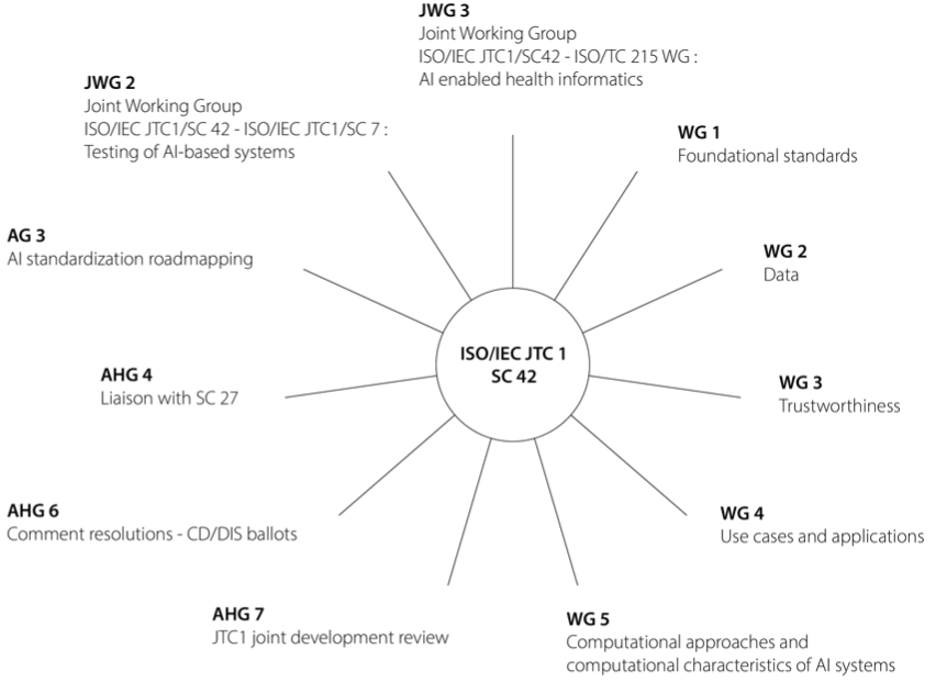

Plusieurs pays cherchent à réglementer l’IA sur leur territoire. Par exemple aux États-Unis avec l’“Algorithmic Accountability Act” (5), en Chine avec le “Algorithmic Recommendation Management Regulations” (6) ou encore au Canada avec “The Artificial Intelligence and Data Act (AIDA)” (7) pour n’en citer que quelques-uns. Beaucoup de textes sont en cours de rédaction ou en attente d’approbation tandis que des standards à vocation mondiale sont en développement à l’ISO, l’IEC et au CEN CENELEC. En 2018, l’ISO/IEC a constitué le sous-comité JTC 1/SC 42 comprenant plus de 300 experts de plus de 30 pays différents qui œuvrent à l’élaboration de standards sur l'intelligence artificielle (8). Actuellement 40 projets ont été lancés, dont 16 ont déjà été publiés. Ces standards cherchent à adresser tous les aspects de l’IA, notamment au niveau algorithmique concernant la robustesse et l’explicabilité des systèmes, pour poser les bases d’un véritable cadre de confiance dans l’IA.

Organisation du ISO/IEC JTC 1/SC 42

En Europe, les initiatives portent autour de l’AI Act, qui est le projet de réglementation de l’IA qui concerne tout algorithme d’IA impactant des citoyens européens, au même titre que la RGPD vis-à-vis de leurs données personnelles. L’AI Act est une initiative de la Commission Européenne qui a mandaté le CEN-CENELEC (l’organisme de standardisation européen) pour lui fournir les standards capables d’opérationnaliser son règlement. Pour répondre aux délais très courts imposés pour la publication de l’AI Act (début 2025), le CEN CENELEC va utiliser les standards de l’ISO/IEC sur l’IA qui sont déjà disponibles. Le but étant d’obtenir au final des standards dits “harmonisés” qui permettront d’avoir une présomption de conformité aux entreprises qui les utiliseront.

En France, un organisme devra être nommé pour délivrer les certifications liées à l’AI Act. Afin de délivrer une certification, cet organisme réalisera des audits de conformité des algorithmes d’IA considérés à haut risque.

L’apport de la Réglementation européenne : l’EU AI ACT

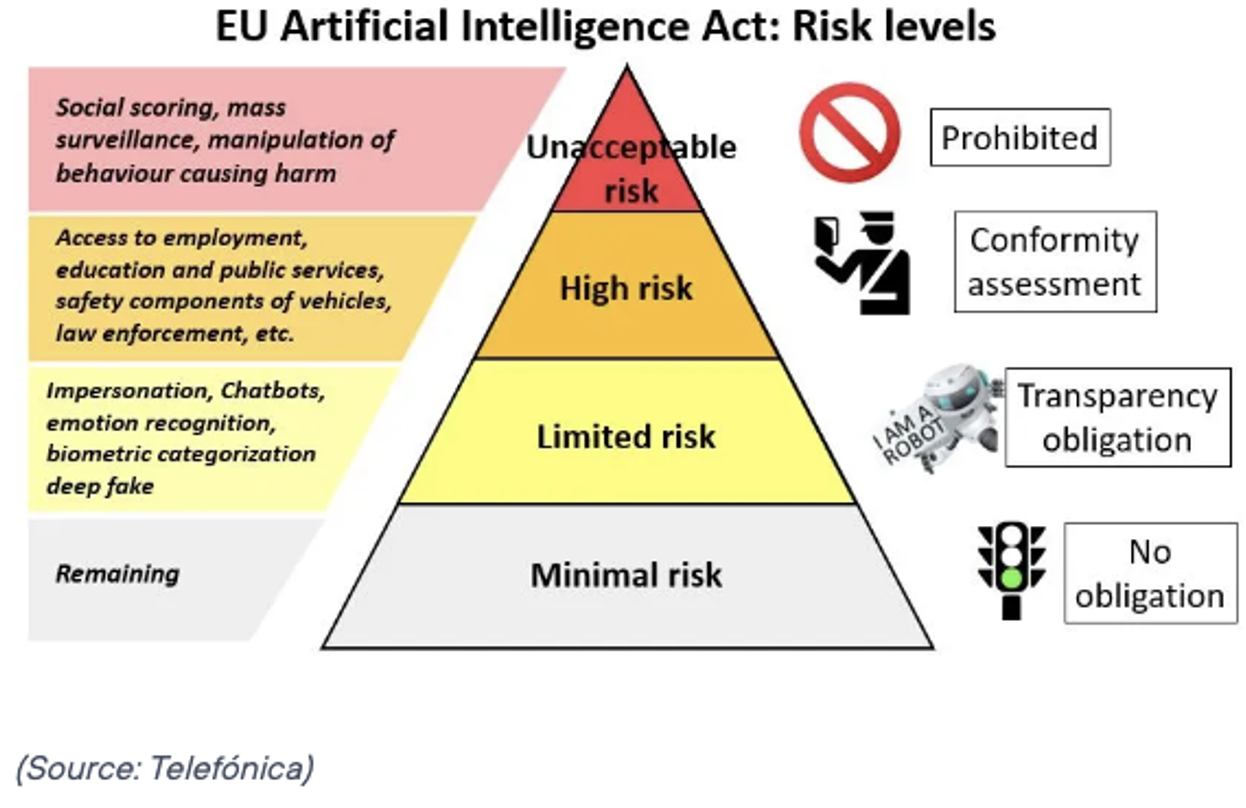

Pour revenir sur le plan Européen, la principale initiative de réglementation s’incarne donc au travers de l’AI Act (9). Le cœur de cette réglementation s’articule autour de la catégorisation des systèmes d’IA au regard de leur finalité, suivant quatre niveaux de risques.

Pyramide des risques de l’EU AI Act (10)

Tout d’abord, la catégorie des risques faibles ou minimaux, pour laquelle il n’y a aucune obligation réglementaire. Il s’agit de l’automatisation du traitement de mails par exemple ou les IA utilisées dans les jeux vidéo.

Le niveau au-dessus concerne les systèmes avec un risque limité. Il y a alors une obligation de transparence vis-à-vis de l’utilisateur concernant le fait qu’il utilise ou interagit avec une IA. Les IA concernées sont par exemple celles basées sur le traitement du langage naturel (chatbots) ou les algorithmes artistiques.

Le dernier niveau où l’IA pourra être déployée dans nos sociétés concerne les systèmes d’IA à haut risque. L’obligation devient alors de se plier à une évaluation de conformité à réaliser avant que le système puisse être déployé. L’évaluation porte sur une multitude de critères. Certains concernent la qualité des jeux de données utilisés afin de minimiser les risques de biais et de discrimination, d’autres portent sur la documentation et la tenue de registres concernant la traçabilité. Mais également sur la transparence, la fourniture d'informations adéquates aux utilisateurs, la supervision humaine, la robustesse, la précision de l’algorithme, ainsi que sur les dispositions en matière de cybersécurité. La réussite de l’évaluation conduira finalement au “marquage CE” du système d’IA (11). Les domaines d’IA concernés sont par exemple : l'accès à l'emploi, l'éducation, les services publics, la gestion des infrastructures critiques, les éléments de sécurité des véhicules, l'application de la loi, l'administration de la justice, etc.

Enfin vient le niveau d’interdiction pour lequel les risques sont jugés inacceptables. Le déploiement des IA concernées est alors tout simplement interdit. Les systèmes d'IA de cette catégorie sont ceux réalisant de l'analyse sociale, de la manipulation du comportement humain de façon subliminale ou à des fins préjudiciables et de la surveillance de masse. Il existe cependant des exceptions possibles concernant les systèmes de surveillance de masse. Pour ce faire, l’organisation devra obtenir une autorisation d’une autorité administrative ou judiciaire et être préalablement encadrée par une loi détaillant l’usage prévu (12). Par exemple, les exceptions peuvent être octroyées dans le cadre d’une compromission de la sécurité nationale, afin de prévenir une menace spécifique, substantielle et imminente pour la vie ou la sécurité des personnes. Il serait donc possible de voir de tels systèmes de surveillance dans des lieux publics tels que des gares ou des aéroports, mais de manière très encadrée.

Avec la sortie officielle du texte de l’AI Act pour début 2025, ces règles deviendront obligatoires et devront être suivies par toutes les entreprises souhaitant déployer un système d’IA en Europe ou interagissant avec des Européens, sur des principes similaires au RGPD.

L’importance de la validation algorithmique

C’est alors que la validation des systèmes d’IA prend tout son sens et devient cruciale pour la conformité, permettant d’obtenir le niveau de confiance technique exigé. Un des piliers de la confiance et donc de la validation concerne la robustesse des IA (13). Durant la validation il sera possible tester la résistance des algorithmes face à des bruits, par exemple en simulant certaines conditions météorologiques pour évaluer la résilience des systèmes d’analyses d’images. Techniquement, les validations statistiques qui seront réalisées pourront s’accompagner de techniques de validation formelle. Ces techniques mathématiques permettent de prouver des propriétés de robustesse sur des ensembles de cas possibles, pour compléter les preuves statistiques de fonctionnement qui sont réalisées sur des échantillons isolés. Qui plus est, le fonctionnement des algorithmes devra être suivi tout au long du cycle de vie des IA, afin de repérer de potentiels changements dans leur conformité. Conformément aux attentes de l’AI Act, les principes de réalisation de cette évaluation seront détaillés dans les standards que va produire le CEN CENELEC. La finalité est toujours d’atteindre un niveau d’exigence et d'assurance qui permettra d'instaurer un cadre de confiance afin que les systèmes d’IA puissent être déployés à grande échelle.

Arnault IOUALALEN et Baptiste AELBRECHT, NUMALIS

➡️ Télécharger la newsletter n°15 (juin 2023) en .PDF

À propos des auteurs : La nécessité de confiance est soutenue par Numalis dont les activités visent à avoir un impact positif sur le déploiement de l'IA dans nos sociétés en développant des outils pour l'explicabilité et à la validation de la robustesse des algorithmes d’IA (14). Numalis porte ces valeurs internationalement grâce à son PDG, Arnault Ioualalen, qui est l’éditeur des standards ISO/IEC portant sur l’évaluation de la robustesse des IA (série de standards ISO/IEC 24029).

__________

Sources

(1) https://aiindex.stanford.edu/wp-content/uploads/2021/03/2021-AI-Index-Report-_Chapter-1.pdf

(2) https://www.apprendre-en-ligne.net/bloginfo/index.php/2008/10/10/79-problemes-d-arrondi

(6) https://library.fes.de/pdf-files/bueros/bruessel/19904.pdf

(8) https://www.iso.org/fr/committee/6794475.html

(9) https://artificialintelligenceact.eu/

(13) https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai

Aucun commentaire

Vous devez être connecté pour laisser un commentaire. Connectez-vous.